1,679 reads

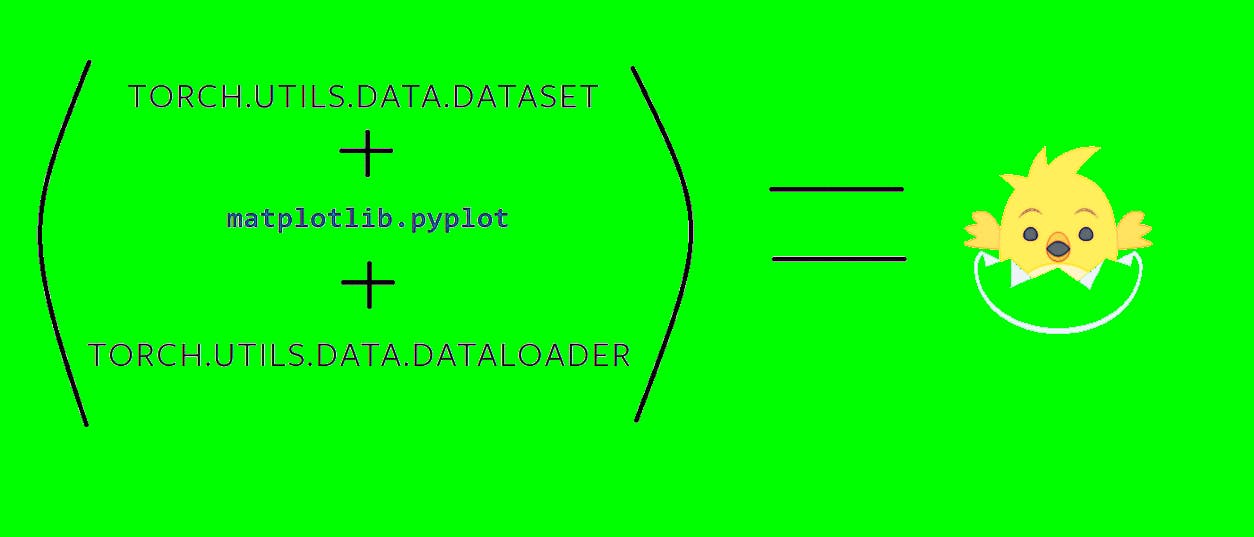

Procesando Datos Para Deep Learning: Datasets, visualizaciones y DataLoaders en PyTorch

by

February 3rd, 2020

Audio Presented by

Dev Advocate Engineer at Starknet Foundation, previously at Starkware and a Machine Learning Engineer at Hugging Face 🤗

About Author

Dev Advocate Engineer at Starknet Foundation, previously at Starkware and a Machine Learning Engineer at Hugging Face 🤗