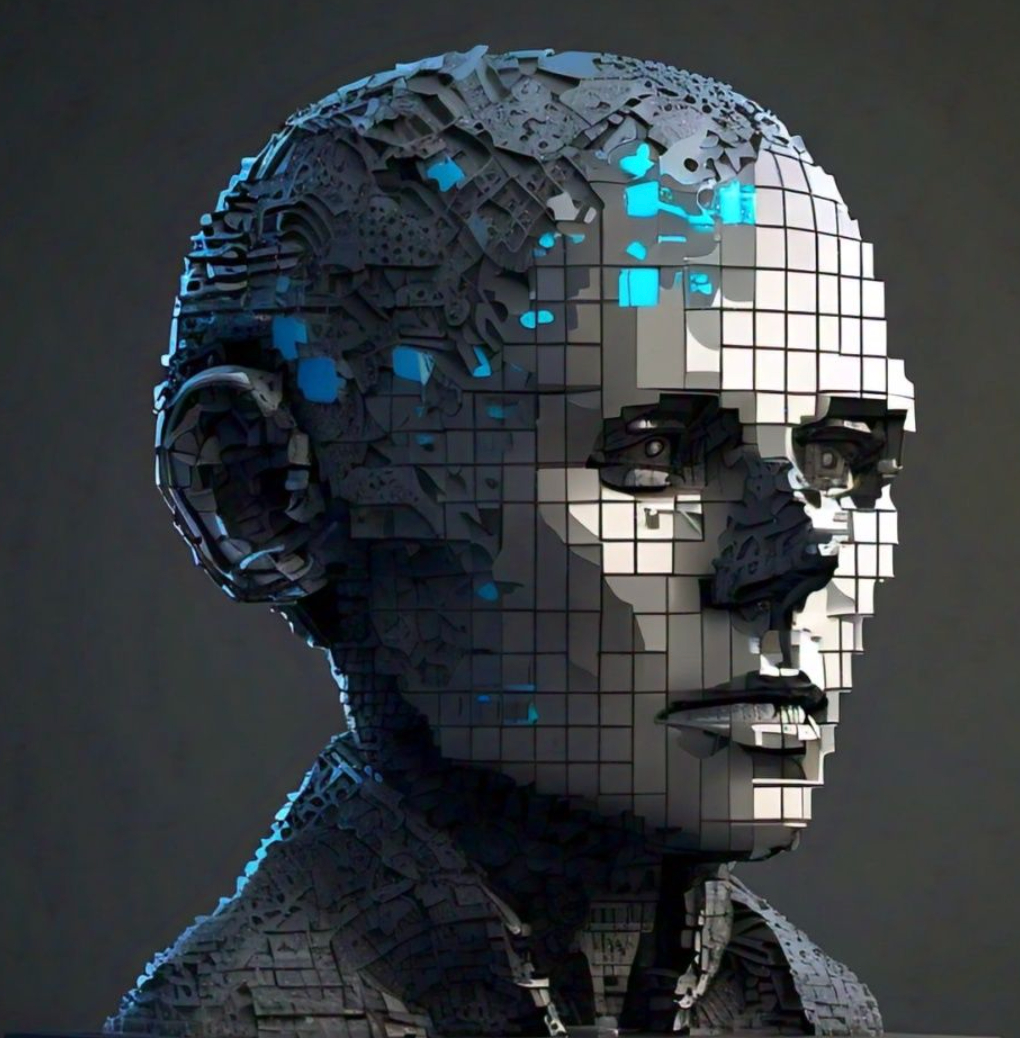

AIthics illuminates the path forward, fostering responsible AI innovation, transparency, and accountability.

Story's Credibility

About Author

AIthics illuminates the path forward, fostering responsible AI innovation, transparency, and accountability.