1,746 reads

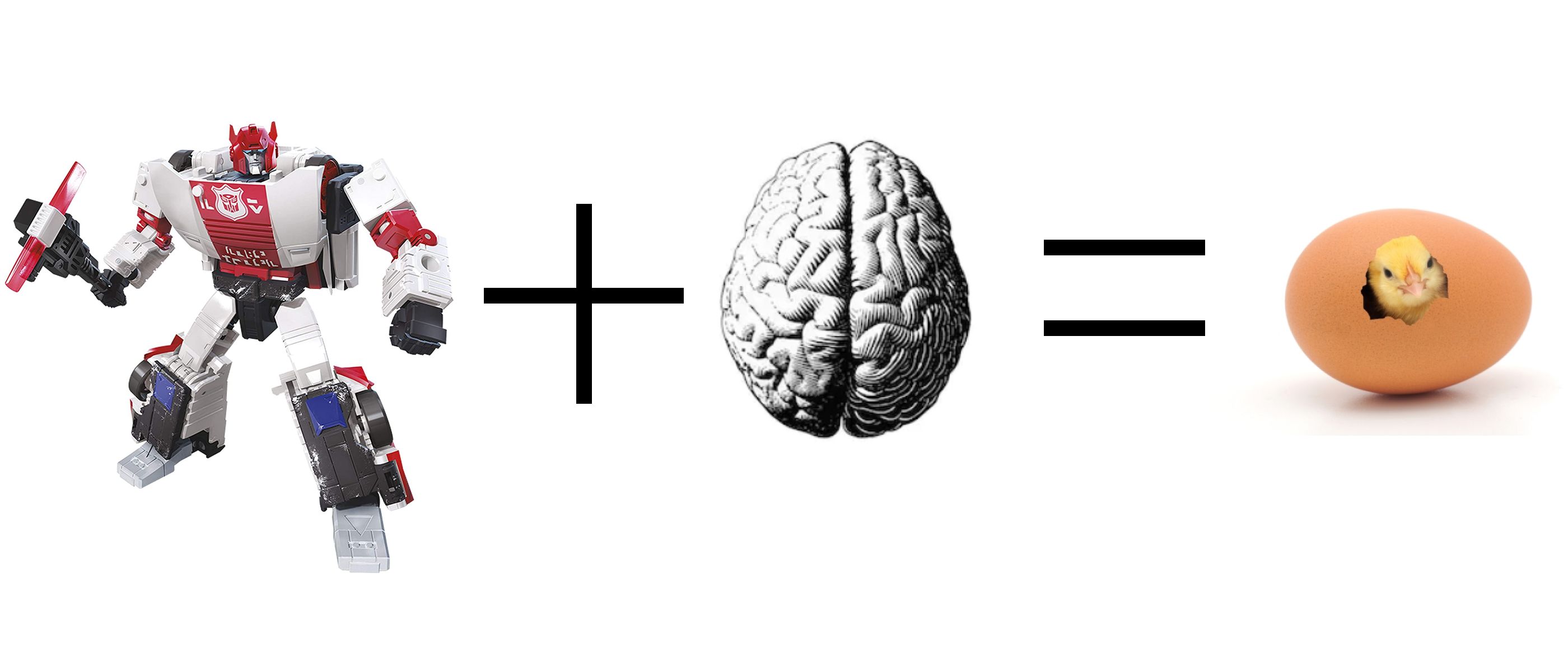

'El transformador ilustrado' una traducción al español

by

October 27th, 2020

Dev Advocate Engineer at Starknet Foundation, previously at Starkware and a Machine Learning Engineer at Hugging Face 🤗

About Author

Dev Advocate Engineer at Starknet Foundation, previously at Starkware and a Machine Learning Engineer at Hugging Face 🤗